当企业还在为GPT-4的高昂调用费买单时,MIT最新研究揭示了“三个臭皮匠赛过诸葛亮”的AI真相:小模型“辩论”不仅成本降低90%,准确率更能反超单一巨型模型。

🔑 Runwise 核心洞察:多智能体辩论 (MAD)

- 打破思维定势 (Mental Stagnation): 单一的大语言模型(LLM)往往陷入“思维退化”,盲目自信地输出错误答案;MAD 通过引入“持有不同观点的智能体”打破这一幻觉。

- 专家评审机制 (Expert Review Board): MAD 模仿人类决策流程,利用“聚合器(主持人)”分发议题,让多个小模型(SLM)进行“提议-反驳-共识”的循环辩论。

- 成本与精度的平衡 (Cost-Efficiency): 实验证明,通过让小模型协同工作,企业可以用 1/10 的算力成本,获得媲美甚至超越 GPT-4 的高质量决策结果。

您在规划企业的AI战略时,是否也常常面临着一个昂贵而棘手的两难选择?

一方面,大型语言模型(LLM),如我们熟知的GPT-4o或Claude 3 Opus,它们的能力极其强大,如同一个经验丰富的“全能战略专家”,能够处理各种复杂的、开放性的问题。但它们的“聘用成本”也极其高昂——不仅运行费用不菲,还需要巨大的计算资源支持,这使得在全公司范围内进行规模化的部署,成为一项沉重的财务负担。

另一方面,小型语言模型(SLM)则像一个个训练有素、成本低廉的“专科医生”。它们运行速度更快、每次查询的成本更低、并且更容易针对某个特定的业务领域(如法律合同分析、客户服务问答等)进行深度定制和优化,甚至可以直接部署在本地设备上。然而,当它们独立面对一个需要跨领域知识和多步推理的复杂问题时,又常常会因为“视野局限”而显得“见识不足”。

我们能否找到一种方法,既能享受到SLM的低成本和高效率,又能获得媲美顶级LLM的高质量、高可靠性的决策与分析结果?

答案是肯定的。一种名为“多智能体辩论”(Multi-Agent Debate, MAD)的革命性AI架构,正为我们揭示了这条极具潜力的道路。这不仅仅是NVIDIA等科技巨头在其最新论文中所强调的“小型语言模型是智能体AI的未来”这一趋势的印证,更是一套能够将这一未来变为现实的、极其精妙的实战蓝图。

第一章:什么是“多智能体辩论”(MAD)?——构建企业AI的“专家评审会”

要理解MAD的精髓,我们首先需要彻底转变对AI的传统认知。它不再是关于训练一个“无所不知”的、单一的AI“大神”,而是关于构建一个由多个、各自拥有不同专长和视角的AI智能体所组成的、能够进行高效协同和思辨的“专家团队”。

核心比喻:一场由AI主导的高规格“专家评审会”

我们可以将“多智能体辩论”(MAD)的工作模式,想象成一场由AI自己组织和参与的、极其严谨、高规格的“专家评审会”,旨在解决一个复杂的核心议题(即用户的查询)。

“首席主持人”(聚合器/Aggregator): 一个能力更强的大型语言模型(LLM)扮演着这场评审会的“首席主持人”和“最终裁决者”的角色。

“与会专家”(多个SLM): 多个更轻量级、更具成本效益的小型语言模型(SLM),则作为各自领域的“特邀专家”出席会议。

会议流程:

“主持人”首先向所有“专家”公布本次会议的核心议题。

各位“专家”基于自己的知识和视角,独立地提出自己的初步观点和论据(第一轮发言)。

紧接着,他们会看到彼此的发言,并可以立即对其他专家的观点提出质疑、补充,甚至直接的反驳(自由辩论)。

为了让辩论更有深度,“主持人”会要求各位“专家”使用外部的“研究工具”(如搜索引擎)、查阅“内部资料库”(如数据库)、并动用自己的“记忆”,来为自己的论点提供事实依据和数据支撑。

“主持人”会根据辩论的进展,进行一轮又一轮的议程推进,不断地总结阶段性共识、澄清争议焦点,直到整个“专家组”就核心议题达成一个逻辑严谨、证据确凿、且高度一致的最终结论。

最后,由“主持人”亲自执笔,将这份凝聚了集体智慧的“最终决议”,撰写成一份详尽、专业的报告,呈现给最初提出议题的用户。

这种通过“让AI自己与自己辩论”的机制,其核心价值在于,它通过一个结构化的、多步骤的、相互验证的上下文构建过程,极大地提升了由小型语言模型(SLM)所组成的“团队”在处理复杂任务时的整体效能和结果可靠性。

想亲眼见证“多智能体”的威力?

无需编写代码,立即体验 Runwise Upskill Pro。我们集成了先进的 Agent 工作流,让您直观感受 AI 如何通过自我反思与协作处理复杂商业任务。

🚀 立即体验顾问级 AI 智能体第二章:“多智能体辩论”是如何工作的?——一次AI“专家评审会”的全程揭秘

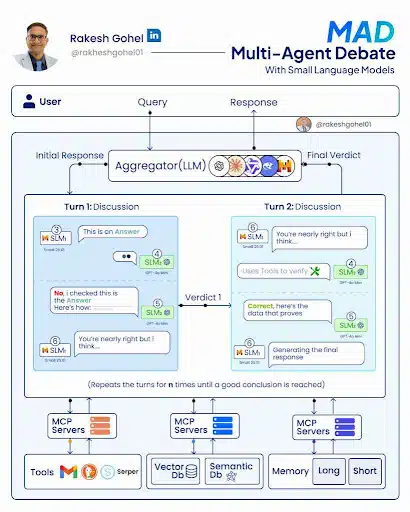

正如图片中所清晰展示的,一次完整的MAD工作流程,是一场精心编排的、动态迭代的“交响乐”。

1. 用户提问 → “主持人”(聚合器)接收并分发议题

流程: 用户的查询请求,首先被发送给作为系统核心的“聚合器(Aggregator)”。这个聚合器通常由一个能力较强的LLM担任,它扮演着“辩论主持人”的角色。它的首要任务是理解用户的核心议题,并决定如何将这个议题有效地分发给参与辩论的多个小型语言模型(SLM)。

2. 第一轮辩论:各自陈述观点与初步思想交锋 (Turn 1: Discussion)

流程: “主持人”将议题分发后,多个SLM“专家”开始独立地、并行地生成它们各自的初步回答。

实战示例(如图所示):

- SLM₁ 首先给出了一个答案:“我认为答案是A。”

- SLM₂ (可能是一个经过微调、更擅长事实核查的GPT-4o Mini模型)在看到SLM₁的答案后,立即提出了挑战:“不对,我查过了。答案应该是B,证据在这里……”

- SLM₃ 则可能扮演一个“调和者”或“补充者”的角色,它看到前两者的交锋后,可能会说:“你(SLM₂)说得基本正确,但我认为在细节上,我们还需要考虑C这一点……”

管理价值: 辩论从一开始就被点燃了。通过这种即时的相互审视和挑战,系统避免了轻信任何一个单一模型的初步结论。

3. 形成“第一轮会议纪要”(Verdict 1)

流程: “主持人”(聚合器)收集并分析第一轮辩论中所有SLM的回答、质疑和补充意见。它会评估其中存在的分歧点、信息缺口,然后生成一份阶段性的“一号决议”(Verdict 1)。这份决议,实际上是一份总结了当前进展、并明确了下一轮辩论焦点的“会议纪要”。

4. 第二轮辩论:深度交锋与工具验证 (Turn 2: Discussion)

流程: 所有的SLM“专家”都会收到这份“一号决议”,并基于此开始第二轮的、更具深度的辩论。

实战示例(如图所示):

SLM₁ 在看到“一号决议”和其他专家的意见后,修正了自己的观点:“你说得基本对,但我认为……”

SLM₂ 则更进一步,它不再仅仅是提出观点,而是开始动用外部工具来验证自己的主张:“完全正确,这里是我从我们的向量数据库中提取的数据,它证明了我的观点。”

SLM₃ 则可能在看到共识逐渐形成后,开始负责“生成最终的、综合性的回应内容”。

管理价值: 在这一轮,辩论的质量实现了质的飞跃。AI不再是“空谈”,而是学会了用**事实和数据(通过调用工具、数据库和记忆系统)**来支撑自己的论点。

5. 迭代多轮(n-times),直至达成共识

流程: 上述的“辩论 → 形成决议 → 再辩论”的过程,将会根据议题的复杂性,迭代地重复多次。在每一轮新的迭代中,随着信息的不断丰富和相互验证,SLM之间的分歧会越来越少,论点会越来越严谨,整个“专家组”的意见会逐渐地、螺旋式地趋向一个高度一致、且证据确凿的共识。

6. 形成“最终决议”并输出报告 (Final Verdict)

流程: 作为“主持人”的“聚合器”,会基于预设的规则(例如,当连续两轮辩论的结果高度一致,或所有关键分歧点都已被充分验证时),来判断辩论是否已经可以结束。

输出: 一旦它决定辩论已经得到了充分的解决,它就会负责整合所有达成的共识,生成一份最终的、代表了整个AI专家团队最高集体智慧的、高质量的回答,呈现给用户。

第三章:指挥AI“梦之队”的关键管理原则

要让这样一套先进的MAD系统高效运作,其背后需要一系列关键的管理原则作为支撑:

角色分工必须高度明确: 赋予每一个参与辩论的SLM一个清晰、专注的角色(例如,一个负责创新性提议,一个负责批判性质疑,一个负责事实核查),可以最大限度地降低其“认知负荷”,让它能更出色地完成自己的核心任务。

初期应优先考虑准确性,后期再优化成本: 在系统搭建的初期,应优先选择能力更强的模型(即使成本稍高)来确保整个辩论和推理流程的准确性和高质量。待流程稳定后,再逐步探索在某些环节用更具成本效益的模型进行替换。

根据任务的复杂性,动态地调配资源: 系统应具备根据用户查询的复杂程度,来动态地决定参与辩论的SLM数量和辩论轮次的能力。

善用统一的AI模型接口(如OpenRouter): 这能让您的系统在未来可以更灵活地、低成本地接入和测试各种不同来源的AI模型。

将确定性的工作流程,交由编排层处理: 那些逻辑确定、无需AI进行复杂推理的步骤(例如,最终报告的格式化、文件发送等),应尽可能地交由工作流自动化平台本身来处理,以节约宝贵的AI模型调用成本。

陷入AI落地难、成本高的困局?

加入 Runwise 2天 AI 战略共创坊。我们不讲空洞理论,Runwise 创始人 将亲自带领您的核心团队,现场拆解业务痛点,共创可落地的多智能体(MAD)解决方案。

✅ 现场出方案 ✅ 找不到增长点不收费

扫码咨询 Ben

获取共创坊大纲

给管理者的启示

“多智能体辩论”(MAD)架构的出现,为企业如何以更低的成本、更快的速度、获得更高质量的AI决策支持,提供了一条极具想象力和实践价值的路径。作为管理者,您可以从中获得以下几点关键启示:

战略性地拥抱“群体智慧”的AI架构,探索用“SLM集群”来替代对单一、昂贵LLM的依赖: 管理者应引导您的AI战略,逐步从过去那种试图寻找一个“万能的”、能够解决所有问题的、单一的、昂贵的LLM的思维定式中转变出来。积极地鼓励您的技术团队,去探索和验证利用一个由多个成本更低、更易于专业化定制的“小型语言模型(SLM)集群”,并通过类似于“多智能体辩论”这样的先进编排框架,来协同解决复杂问题的可行性。这不仅可能在长期为您带来巨大的成本节约,更能通过专业化分工,在许多特定任务上获得比通用LLM更高的性能和可靠性。

将投资的重点,从仅仅关注“AI模型本身”,战略性地转向构建“高质量的辩论与验证机制”: “多智能体辩论”模式的精髓,并不仅仅在于参与辩论的那些AI模型,更在于整个“辩论的过程和规则”。管理者需要深刻地认识到,要构建一个真正可靠的企业级AI系统,就必须大力投资于构建其“辩论与验证的基础设施”。这意味着,您需要为您的AI智能体团队,提供丰富的、高质量的、可供它们进行事实核查的“内部知识库”和“外部工具集”;并且,您需要支持技术团队,去设计和优化那些能够鼓励AI进行批判性思考、相互验证、并能从错误中学习的、强大的“编排逻辑”。

从“可控的内部决策支持”场景开始,安全、稳健地试点和推广“多智能体辩论”系统: “多智能体辩论”的过程,因其具有一定的迭代性和非确定性,使其在初期阶段,尤其适合应用于那些对内的、非直接面向客户的、以提升决策质量为核心目标的场景。管理者可以率先在企业内部,选择一些例如“复杂的市场竞争情报分析”、“新产品技术可行性评估”、“内部疑难技术问题诊断”等应用场景,来试点部署一个MAD系统。这不仅能让组织安全、可控地去驾驭和利用这种先进AI架构的强大能力,更能在此过程中,逐步地理解其行为模式、建立起组织对它的信任,为未来将其更广泛地应用于更核心、甚至面向客户的业务场景中,打下坚实的基础。

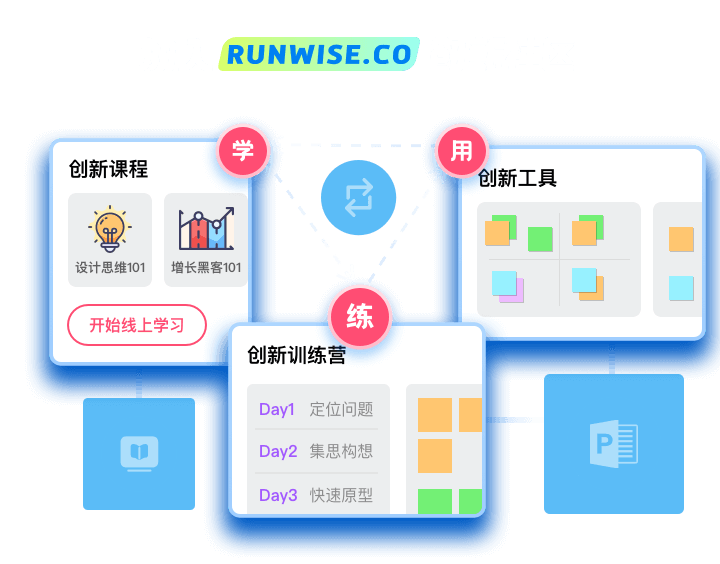

想深入学习如何为您的企业设计和构建这样一支能够自我辩论、自我进化的、高效协同的AI“梦之队”,将AI技术真正转化为企业的战略决策优势吗?加入「老J教创新」会员专区,每天获取更多AI创新战略、多智能体架构深度解读与前沿实战案例,助您成为驾驭AI未来的卓越领导者!